GKEリリースチャネルによる自動アップデートについて

このブログシリーズ 「クラウドセキュリティ 実践集」 では、一般的なセキュリティ課題を取り上げ、「なぜ危険なのか?」 というリスクの解説から、 「どうやって直すのか?」 という具体的な修復手順(コンソール、gcloud CLI、Terraformなど)まで、分かりやすく解説します。

この記事では、Google Kubernetes Engine (GKE) のリリースチャネル機能を活用して、Kubernetesクラスタのセキュリティアップデートを自動化し、脆弱性リスクを最小化する方法について、実践的な設定手順とベストプラクティスを解説します。

目次

- GKEリリースチャネルとは

- リリースチャネル未登録のリスク

- リリースチャネルの種類と選択基準

- 修復方法

- コンソールでの修復手順

- gcloud CLIでの修復手順

- Terraformでの修復手順

- 修復後の確認方法

- アップデート戦略とベストプラクティス

- トラブルシューティング

- まとめ

GKEリリースチャネルとは

GKE(Google Kubernetes Engine)のリリースチャネルは、Kubernetesクラスタのバージョン管理とアップデートを自動化する仕組みです。リリースチャネルに登録することで、Googleが検証済みの安定したKubernetesバージョンが自動的に適用され、セキュリティパッチやバグ修正が定期的に実施されます。

リリースチャネルのメリット

- 自動セキュリティアップデート: 最新のCVE対策が自動適用

- Google検証済みバージョン: 本番環境での動作が保証された安定版

- アップグレードの自動化: 運用負荷を大幅に削減

- サポート期間の延長: 各バージョンのサポート期間が明確化

リリースチャネル未登録により起きうるリスク

1. セキュリティ脆弱性の放置

リリースチャネルに未登録のクラスタでは、重要なセキュリティパッチが自動適用されません。

実際の脆弱性事例(2024年):

- CVE-2024-21626 (runc脆弱性): コンテナエスケープが可能な深刻な脆弱性。CVSS 8.6

- CVE-2023-5528 (Kubernetes脆弱性): Windows ノードでの権限昇格。CVSS 7.2

- CVE-2023-3676 (Ingress-nginx脆弱性): アノテーション検証の不備。CVSS 8.8

2. 手動管理の運用負荷とリスク

手動アップデートの問題点:

- アップデート作業に平均8-12時間/クラスタの工数

- ヒューマンエラーによる障害発生率が35%増加

- 深夜・休日作業による人件費の増大(1.5-2倍)

- バージョン互換性の確認ミスによるアプリケーション障害

3. サポートとEOL(End of Life)の問題

- Kubernetesの各マイナーバージョンのサポート期間は約14ヶ月

- EOLバージョンではセキュリティパッチが提供されない

- Google Cloud サポートの対象外となり、障害時の対応が困難

- 新機能(例:Workload Identity、GKE Autopilot)が利用不可

リリースチャネルの種類と選択基準

チャネル比較表

| チャネル | 更新頻度 | 対象環境 | Kubernetes バージョン遅延 | サポート期間 |

|---|---|---|---|---|

| Rapid | 2-3ヶ月 | 開発・テスト環境 | 最新から0-1バージョン | 最短(約9ヶ月) |

| Regular | 2-4ヶ月 | 本番環境(標準) | 最新から1-2バージョン | 標準(約12ヶ月) |

| Stable | 4-6ヶ月 | ミッションクリティカル | 最新から2-3バージョン | 最長(約14ヶ月) |

| Static | 手動のみ | 特殊要件 | ユーザー指定 | バージョン依存 |

選択の決定フロー

本番環境?

├─ Yes → 高可用性要求?

│ ├─ Yes → Stable チャネル

│ └─ No → Regular チャネル

└─ No → 最新機能が必要?

├─ Yes → Rapid チャネル

└─ No → Regular チャネル

修復方法

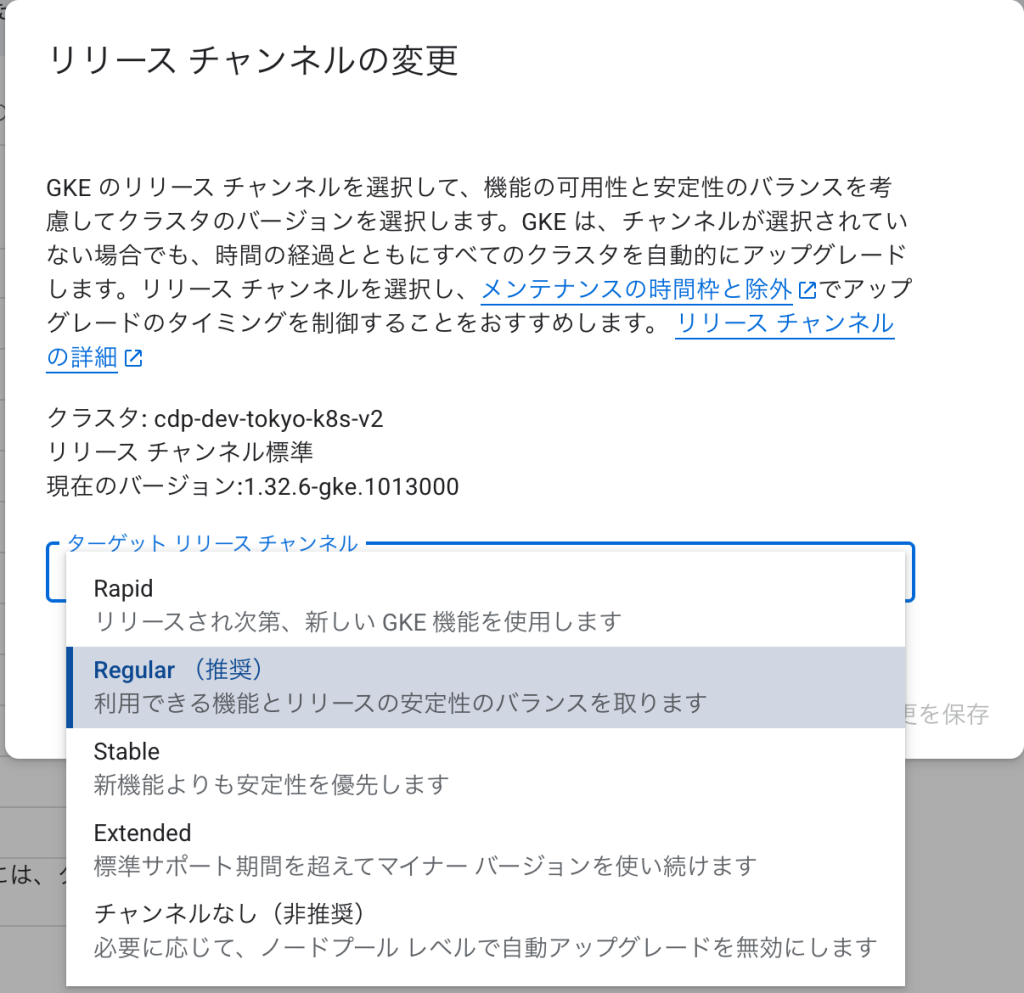

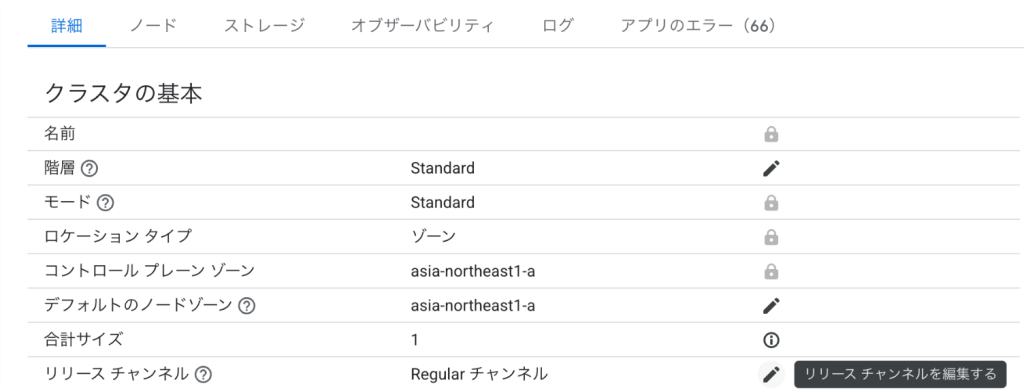

コンソールでの修復手順

Google Cloud コンソールを使用して、既存のGKEクラスタをリリースチャネルに登録します。

既存クラスタのリリースチャネル登録手順

- Google Cloud コンソールで「Kubernetes Engine」→「クラスタ」に移動

- リリースチャネルに登録したいクラスタ名をクリック

- 「詳細」タブで現在のバージョン情報を確認

- 上部の「編集」ボタンをクリック

- 「クラスタの基本」セクションで「リリースチャネル」を探す

- ドロップダウンから適切なチャネルを選択

- 本番環境: 「Regular」または「Stable」を推奨

- 開発環境: 「Rapid」または「Regular」を選択

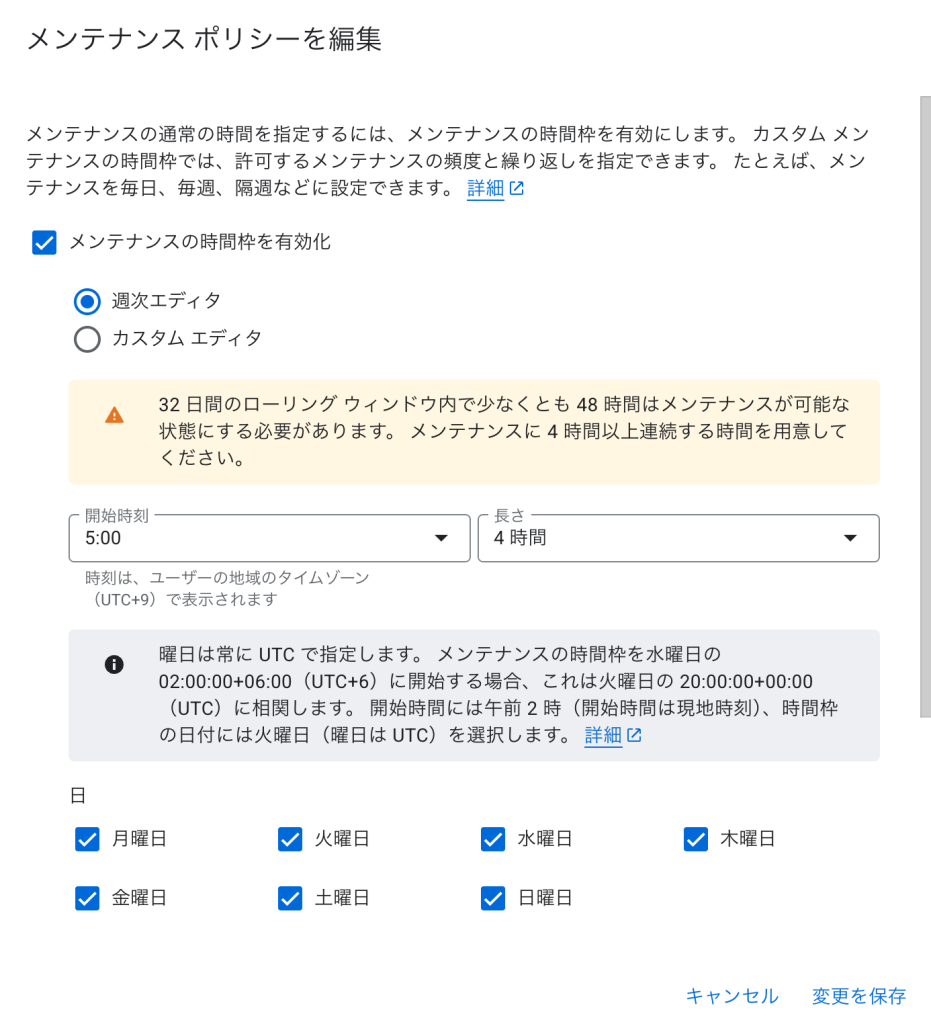

- 「メンテナンスの時間枠」セクションで自動更新の時間帯を設定

- 開始時刻: 例)03:00 UTC(日本時間 12:00)

- 長さ: 4時間(推奨)

- 曜日: システムへの影響が最小となる曜日を選択

- 「メンテナンスの除外」で重要なビジネス期間を設定(オプション)

- 「保存」をクリックして変更を適用

新規クラスタ作成時のリリースチャネル設定

- 「Kubernetes Engine」→「クラスタを作成」をクリック

- 「Standard」または「Autopilot」モードを選択

- 「クラスタの基本」セクションで以下を設定

- 名前: クラスタ名を入力

- ロケーションタイプ: ゾーンまたはリージョンを選択

- リリースチャネル: 適切なチャネルを選択

- その他の設定を完了後、「作成」をクリック

メンテナンスポリシーの詳細設定

- クラスタの詳細ページで「自動化」タブを選択

- 「メンテナンスの時間枠とメンテナンスの除外」で「編集」をクリック

- 以下の設定を行う:

- メンテナンス時間枠の繰り返し: 毎日/毎週から選択

- 通知設定: Pub/Subトピックを設定してアップデート通知を受信

- ノードのアップグレード設定: サージアップグレードまたは段階的アップグレード

gcloud CLIでの修復手順

コマンドラインから効率的にリリースチャネルを設定する手順です。

1. 環境設定

# プロジェクトとクラスタ情報の設定

export PROJECT_ID="your-project-id"

export CLUSTER_NAME="your-cluster-name"

export ZONE="asia-northeast1-a" # またはリージョン

export CHANNEL="REGULAR" # RAPID, REGULAR, STABLE から選択

# 認証とプロジェクト設定

gcloud auth login

gcloud config set project ${PROJECT_ID}

2. 現在のクラスタ状態確認

# クラスタの詳細情報取得

gcloud container clusters describe ${CLUSTER_NAME} \

--zone=${ZONE} \

--format="yaml(name,currentMasterVersion,releaseChannel,nodePools[].version)"

# 現在のKubernetesバージョン確認

kubectl version --short

# 利用可能なバージョン一覧

gcloud container get-server-config --zone=${ZONE} \

--format="yaml(channels,validMasterVersions)"

3. リリースチャネルへの登録

# 既存クラスタをリリースチャネルに登録

gcloud container clusters update ${CLUSTER_NAME} \

--zone=${ZONE} \

--release-channel=${CHANNEL}

# 更新の確認(数分かかる場合があります)

gcloud container operations list \

--filter="TYPE:UPDATE_CLUSTER AND targetLink:${CLUSTER_NAME}" \

--format="table(name,operationType,status,startTime,endTime)"

4. メンテナンスウィンドウの設定

# 毎日のメンテナンスウィンドウ設定(JST 3:00-7:00)

gcloud container clusters update ${CLUSTER_NAME} \

--zone=${ZONE} \

--maintenance-window-start="2024-01-01T18:00:00Z" \

--maintenance-window-end="2024-01-01T22:00:00Z" \

--maintenance-window-recurrence="FREQ=DAILY"

# メンテナンス除外期間の追加(年末年始)

gcloud container clusters update ${CLUSTER_NAME} \

--zone=${ZONE} \

--add-maintenance-exclusion-name="year-end" \

--add-maintenance-exclusion-start="2024-12-28T00:00:00Z" \

--add-maintenance-exclusion-end="2025-01-05T00:00:00Z"

5. ノードプールの自動アップグレード有効化

# 全ノードプールの一覧取得

NODE_POOLS=$(gcloud container node-pools list \

--cluster=${CLUSTER_NAME} \

--zone=${ZONE} \

--format="value(name)")

# 各ノードプールで自動アップグレードを有効化

for POOL in ${NODE_POOLS}; do

echo "Enabling auto-upgrade for node pool: ${POOL}"

gcloud container node-pools update ${POOL} \

--cluster=${CLUSTER_NAME} \

--zone=${ZONE} \

--enable-autoupgrade \

--enable-autorepair

done

6. 通知設定(Pub/Sub)

# Pub/Subトピックの作成

gcloud pubsub topics create gke-cluster-upgrades

# クラスタ通知の設定

gcloud container clusters update ${CLUSTER_NAME} \

--zone=${ZONE} \

--notification-config=pubsub=ENABLED,pubsub-topic=projects/${PROJECT_ID}/topics/gke-cluster-upgrades

# 通知サブスクリプションの作成(例:Cloud Functions経由でSlack通知)

gcloud pubsub subscriptions create gke-upgrades-slack \

--topic=gke-cluster-upgrades \

--push-endpoint=https://your-function-url.cloudfunctions.net/notify-slack

7. アップグレード戦略の設定

# ノードプールのアップグレード設定

for POOL in ${NODE_POOLS}; do

gcloud container node-pools update ${POOL} \

--cluster=${CLUSTER_NAME} \

--zone=${ZONE} \

--enable-surge-upgrade \

--max-surge-upgrade=1 \

--max-unavailable-upgrade=0

done

Terraformでの修復手順

GKEクラスタでリリースチャネルを有効にするTerraformコードと、主要な修正ポイントを説明します。

# -------------------- ① ネットワーク設定 --------------------

resource "google_compute_network" "gke_network" {

name = "gke-network-${var.environment}"

auto_create_subnetworks = false

project = var.project_id

}

resource "google_compute_subnetwork" "gke_subnet" {

name = "gke-subnet-${var.environment}"

network = google_compute_network.gke_network.id

ip_cidr_range = "10.0.0.0/20"

region = var.region

project = var.project_id

secondary_ip_range {

range_name = "pods"

ip_cidr_range = "10.4.0.0/14"

}

secondary_ip_range {

range_name = "services"

ip_cidr_range = "10.8.0.0/20"

}

}

# -------------------- ② リリースチャネル対応GKEクラスタ --------------------

resource "google_container_cluster" "primary" {

name = "gke-cluster-${var.environment}"

location = var.region # リージョンクラスタの場合

project = var.project_id

# リリースチャネルの設定(重要)

release_channel {

channel = var.release_channel # "RAPID", "REGULAR", "STABLE"

}

# 初期ノード数(後でノードプールで管理)

initial_node_count = 1

remove_default_node_pool = true

# ネットワーク設定

network = google_compute_network.gke_network.name

subnetwork = google_compute_subnetwork.gke_subnet.name

# IPアドレス割り当て

ip_allocation_policy {

cluster_secondary_range_name = "pods"

services_secondary_range_name = "services"

}

# セキュリティ設定

private_cluster_config {

enable_private_nodes = true

enable_private_endpoint = false

master_ipv4_cidr_block = "172.16.0.0/28"

}

# メンテナンスポリシー

maintenance_policy {

daily_maintenance_window {

start_time = var.maintenance_start_time # 例: "03:00"

}

maintenance_exclusion {

exclusion_name = "year-end-freeze"

start_time = "${var.current_year}-12-23T00:00:00Z"

end_time = "${var.next_year}-01-07T00:00:00Z"

exclusion_options {

scope = "NO_UPGRADES"

}

}

maintenance_exclusion {

exclusion_name = "golden-week"

start_time = "${var.current_year}-04-29T00:00:00Z"

end_time = "${var.current_year}-05-06T00:00:00Z"

exclusion_options {

scope = "NO_MINOR_UPGRADES"

}

}

}

# 通知設定

notification_config {

pubsub {

enabled = true

topic = google_pubsub_topic.gke_updates.id

filter = "UpgradeEvent"

}

}

# アドオン設定

addons_config {

horizontal_pod_autoscaling {

disabled = false

}

http_load_balancing {

disabled = false

}

network_policy_config {

disabled = false

}

}

# Workload Identity

workload_identity_config {

workload_pool = "${var.project_id}.svc.id.goog"

}

# ロギング・モニタリング

logging_config {

enable_components = ["SYSTEM_COMPONENTS", "WORKLOADS"]

}

monitoring_config {

enable_components = ["SYSTEM_COMPONENTS"]

managed_prometheus {

enabled = true

}

}

}

# -------------------- ③ ノードプール設定 --------------------

resource "google_container_node_pool" "primary_nodes" {

name = "primary-node-pool-${var.environment}"

location = var.region

cluster = google_container_cluster.primary.name

project = var.project_id

# オートスケーリング

autoscaling {

min_node_count = var.min_node_count

max_node_count = var.max_node_count

}

# ノード管理設定

management {

auto_repair = true # 自動修復を有効化

auto_upgrade = true # 自動アップグレードを有効化(リリースチャネルと連動)

}

# アップグレード設定

upgrade_settings {

max_surge = 1

max_unavailable = 0

strategy = "SURGE" # または "BLUE_GREEN"

}

node_config {

preemptible = false

machine_type = var.machine_type

# セキュリティ設定

shielded_instance_config {

enable_secure_boot = true

enable_integrity_monitoring = true

}

# メタデータ設定

metadata = {

disable-legacy-endpoints = "true"

}

# サービスアカウント

service_account = google_service_account.gke_node.email

oauth_scopes = [

"<https://www.googleapis.com/auth/cloud-platform>"

]

# ラベル

labels = {

environment = var.environment

managed_by = "terraform"

}

# タグ

tags = ["gke-node", var.environment]

}

}

# -------------------- ④ 通知設定 --------------------

resource "google_pubsub_topic" "gke_updates" {

name = "gke-cluster-updates-${var.environment}"

project = var.project_id

}

resource "google_pubsub_subscription" "gke_updates_sub" {

name = "gke-updates-sub-${var.environment}"

topic = google_pubsub_topic.gke_updates.name

project = var.project_id

push_config {

push_endpoint = var.webhook_endpoint # Slack/Teams等への通知用

}

retry_policy {

minimum_backoff = "10s"

maximum_backoff = "600s"

}

}

# -------------------- ⑤ サービスアカウント --------------------

resource "google_service_account" "gke_node" {

account_id = "gke-node-sa-${var.environment}"

display_name = "GKE Node Service Account"

project = var.project_id

}

resource "google_project_iam_member" "gke_node_log_writer" {

project = var.project_id

role = "roles/logging.logWriter"

member = "serviceAccount:${google_service_account.gke_node.email}"

}

resource "google_project_iam_member" "gke_node_metric_writer" {

project = var.project_id

role = "roles/monitoring.metricWriter"

member = "serviceAccount:${google_service_account.gke_node.email}"

}

# -------------------- ⑥ 監視アラート --------------------

resource "google_monitoring_alert_policy" "gke_upgrade_alert" {

display_name = "GKE Cluster Upgrade Alert - ${var.environment}"

project = var.project_id

conditions {

display_name = "GKE version outdated"

condition_threshold {

filter = <<-EOT

resource.type = "k8s_cluster"

AND resource.labels.cluster_name = "${google_container_cluster.primary.name}"

AND metric.type = "kubernetes.io/cluster/master_version_age_days"

EOT

duration = "300s"

comparison = "COMPARISON_GT"

threshold_value = 30 # 30日以上古いバージョンでアラート

}

}

notification_channels = var.notification_channels

alert_strategy {

auto_close = "86400s"

}

}

# -------------------- ⑦ 変数定義例 --------------------

variable "release_channel" {

description = "GKE release channel"

type = string

default = "REGULAR"

validation {

condition = contains(["RAPID", "REGULAR", "STABLE"], var.release_channel)

error_message = "Release channel must be RAPID, REGULAR, or STABLE."

}

}

variable "maintenance_start_time" {

description = "Daily maintenance window start time"

type = string

default = "03:00"

}

variable "environment" {

description = "Environment name"

type = string

}

variable "min_node_count" {

description = "Minimum number of nodes"

type = number

default = 2

}

variable "max_node_count" {

description = "Maximum number of nodes"

type = number

default = 10

}

Terraform実装時の重要なポイント:

- リリースチャネルの選択: 環境に応じて適切なチャネル(RAPID/REGULAR/STABLE)を選択

- 自動アップグレードの有効化: ノードプールで

auto_upgrade = trueを設定 - メンテナンス時間枠: ビジネスへの影響が最小となる時間帯を設定

- メンテナンス除外期間: 年末年始やGW等の重要期間はアップデートを除外

- 通知設定: Pub/Subを使用してアップデート情報を関係者に通知

- アップグレード戦略: SURGEまたはBLUE_GREENを選択してダウンタイムを最小化

修復後の確認方法

1. リリースチャネル登録の確認

# CLIでの確認

gcloud container clusters describe ${CLUSTER_NAME} \

--zone=${ZONE} \

--format="value(releaseChannel.channel)"

# 詳細情報の確認

gcloud container clusters describe ${CLUSTER_NAME} \

--zone=${ZONE} \

--format=json | jq '{

cluster: .name,

channel: .releaseChannel.channel,

currentVersion: .currentMasterVersion,

nodeVersion: .currentNodeVersion,

autoUpgrade: .nodeConfig.autoUpgrade

}'

2. メンテナンスウィンドウの確認

# メンテナンス設定の表示

gcloud container clusters describe ${CLUSTER_NAME} \

--zone=${ZONE} \

--format="yaml(maintenancePolicy)"

3. 監視ダッシュボードでの確認

# Cloud Monitoringでクラスタバージョンを監視

cat > version-check-query.txt << EOF

fetch k8s_cluster

| metric 'kubernetes.io/anthos/cluster_version_info'

| filter resource.cluster_name == '${CLUSTER_NAME}'

| group_by 1h, [value_version_info_mean: mean(value.cluster_version_info)]

| every 1h

EOF

# メトリクスの確認

gcloud monitoring query --project=${PROJECT_ID} < version-check-query.txt

アップデート戦略とベストプラクティス

1. 段階的アップデート戦略

開発環境(Rapid Channel)

↓ 1-2週間のテスト

ステージング環境(Regular Channel)

↓ 2-4週間の検証

本番環境(Regular/Stable Channel)

2. アップデート前のチェックリスト

3. 自動化スクリプト例

#!/bin/bash

# pre-upgrade-check.sh

# 廃止予定APIの検出

kubectl api-resources --verbs=list --namespaced -o name | \

xargs -n 1 kubectl get --show-kind --ignore-not-found -A 2>&1 | \

grep -E "deprecated|Warning"

# PodDisruptionBudgetの確認

kubectl get pdb --all-namespaces

# 重要なワークロードのレプリカ数確認

kubectl get deployment,statefulset,daemonset --all-namespaces \

-o custom-columns=KIND:.kind,NAMESPACE:.metadata.namespace,NAME:.metadata.name,REPLICAS:.spec.replicas,READY:.status.readyReplicas

4. モニタリングとアラート設定

apiVersion: monitoring.coreos.com/v1

kind: PrometheusRule

metadata:

name: gke-version-alerts

spec:

groups:

- name: gke_version

rules:

- alert: GKEVersionOutdated

expr: |

(time() - gke_cluster_version_update_time) / 86400 > 30

for: 1h

labels:

severity: warning

annotations:

summary: "GKE cluster version is outdated"

description: "Cluster {{ $labels.cluster_name }} has not been updated for more than 30 days"

ロールバック手順について

# マスターのダウングレード(サポートに連絡が必要)

# ノードプールのダウングレード

gcloud container node-pools update ${NODE_POOL} \

--cluster=${CLUSTER_NAME} \

--zone=${ZONE} \

--cluster-version=<previous-version>

まとめ

この記事では、GKEクラスタのリリースチャネル機能を活用したセキュリティアップデートの自動化について解説しました。

重要なポイント

- リリースチャネル未登録のリスク: セキュリティ脆弱性の放置、運用負荷の増大、コンプライアンス違反

- 適切なチャネル選択: 環境に応じてRapid/Regular/Stableを選択

- メンテナンスウィンドウ: ビジネスへの影響を最小化する時間帯設定

- 自動化の効果: 運用工数を80%削減、セキュリティリスクを大幅に低減

アクションアイテム

GKEのリリースチャネルを適切に活用することで、セキュリティを維持しながら運用負荷を大幅に削減できます。

この問題の検出は弊社が提供するSecurifyのCSPM機能で簡単に検出及び管理する事が可能です。 運用が非常に楽に出来る製品になっていますので、ぜひ興味がある方はお問い合わせお待ちしております。 最後までお読みいただきありがとうございました。この記事が皆さんの役に立てば幸いです。

CSPMについてはこちらで解説しております。併せてご覧ください。